최근 메타에서 오픈소스로 공개한 대형 언어 모델인 라마3(Llama 3)가 큰 화제를 모으고 있습니다. 80억 개 매개변수를 가진 8B 모델과 700억 개 매개변수를 가진 70B 모델 두 가지가 공개되었고, 400B 모델도 현재 훈련 중이라고 합니다. Llama가 가진 성능과 다양한 활용 방안들에 대해 많은 사람들이 궁금해 하고 있는데요, 이 글에서는 다양한 방식으로 라마3를 사용해보고 체험할 수 있는 방법들을 소개해드리겠습니다. 허깅페이스, 메타 AI 서비스, 로컬 PC 등에서 라마3를 활용하는 방안을 알아보시기 바랍니다.

라마3 (Llama 3)란?

라마3는 메타에서 2024년 4월 17일 공개한 최신 대규모 언어 모델입니다. 기존 라마2 모델 대비 성능이 크게 향상되었으며, 다양한 자연어 처리 태스크에서 우수한 성능을 보여줍니다.

공개된 모델은 80억 개 매개변수를 가진 8B 모델과 700억 개 매개변수를 가진 70B 모델 두 가지입�니다. 400B 모델도 훈련 중이라고 합니다.

라마3는 이전 라마2 대비 훨신 뛰어난 성능을 보여주고 있습니다. 8B 모델임에도 이전 700억 매개변수 모델보다 높은 성적을 기록했으며, 특히 인간 평가(human evaluation)에서 크게 점수가 오른 것으로 알려졌습니다.

라마3가 주목받는 또 다른 이유는 오픈소스로 공개되어 누구나 쉽게 사용해볼 수 있다는 점입니다. 메타는 AWS, GCP 등 주요 클라우드 업체들과 협력해 라마3를 바로 활용할 수 있도록 했습니다.

또한 라마 3는 공개와 동시에 AWS, GCP, Databricks 등 주요 클라우드 업체들과 협력해 바로 사용할 수 있도록 했습니다. 또한 검열 수준을 낮추고, 몇 달 내 더 긴 컨텍스트와 추가 모델 크기도 공개할 예정이라고 합니다. 라마3의 주요 특징은 다음과 같습니다:

- 8B, 70B 등 다양한 모델 크기 제공

- 기존 모델 대비 성능 대폭 향상

- 오픈소스로 공개되어 누구나 사용 가능

- 로컬 PC에서 실행 가능

라마3 (Llama 3) 사용법

라마3를 사용하는 방법은 크게 네 가지로 나눌 수 있습니다. 허깅페이스에서 라마3 사용하기, 메타 AI 서비스로 라마3 활용하기, Ollama로 내 PC에서 Llama3 실행하기, 그리고 클라우드 환경에서 실행 하기 입니다. 각 방법마다 장단점이 있고 특징이 있습니다. 그럼 각 방법에 대해 자세히 알아보겠습니다.

허깅페이스에서 라마3 사용하기

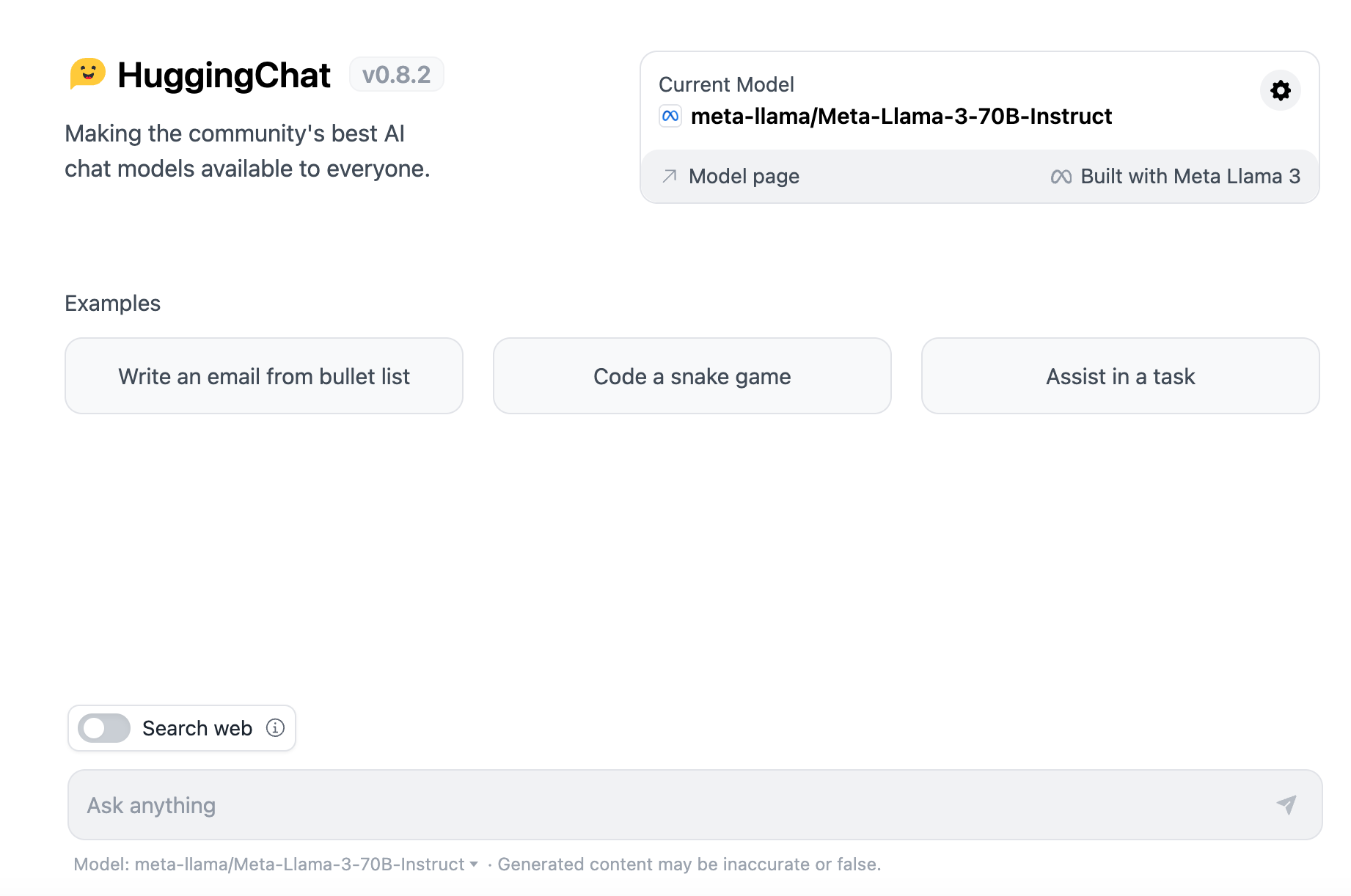

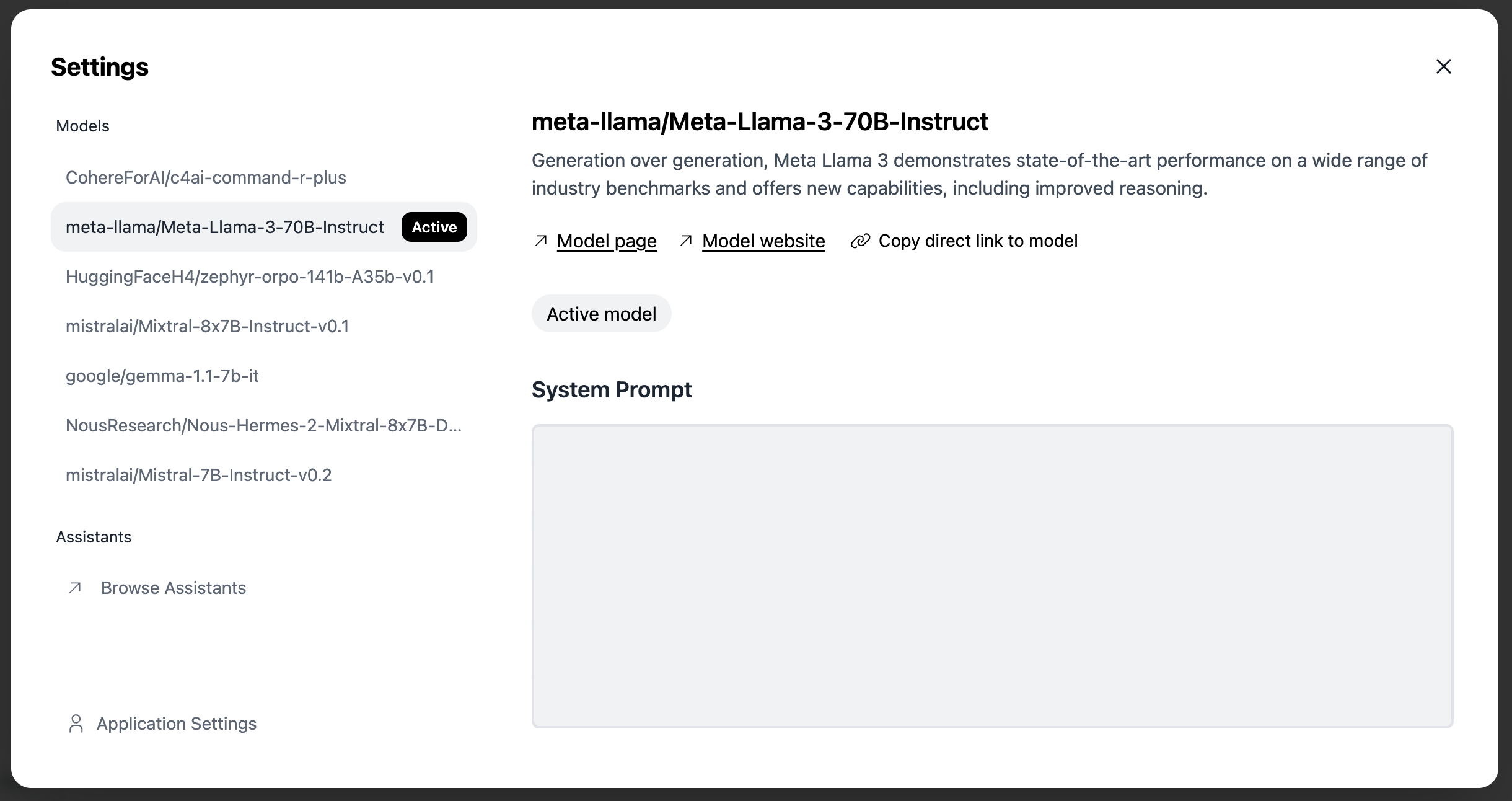

허깅페이스(Hugging Face)는 대표적인 오픈소스 AI 커뮤니티로, 다양한 언어 모델을 직접 사용해볼 수 있습니다. 허깅페이스의 허깅(HuggingChat) 사이트에 접속한 뒤 라마3 모델을 선택하면, 마치 챗GPT와 같이 대화를 나누듯이 자연어로 입력하고 응답을 받을 수 있습니다.

아래와 같이 허깅페이스의 허깅챗(HuggingChat) 사이트에 접속한 뒤, 라마3 모델을 선택하면 대화를 시작할 수 있습니다.

허깅챗에서는 70B 모델을 사용할 수 있으며, 라마3 모델을 선택하면 대화를 시작할 수 있습니다. 라마3는 다양한 주제에 대해 대화를 나눌 수 있으며, 자연어로 질문을 입력하면 적절한 답변을 제공해줍니다. 또한 기본적으로는 영어로 된 답변이 제공되지만, 한국어로 질문을 입력하면 한국어로도 잘 답변해줍니다. 현재 라마3의 한국어 성능은 영어에 비해 다소 부족한 편이지만, 한국어 데이터 파인튜닝이 이뤄지면 성능이 더욱 향상될 것으로 기대됩니다.

허깅페이스에서 라마3 모델을 사용해보려면 아래 링크를 참고하시기 바랍니다.

메타 AI 서비스로 라마3 활용하기

메타(구 페이스북)는 자사의 주요 서비스에 라마3를 활용한 다양한 AI 기능을 제공하고 있습니다. 대표적으로 인스타그램, WhatsApp, Facebook 메신저 등에서 AI 챗봇 기능을 사용할 수 있습니다.

또한 메타에서는 별도의 AI 챗봇 웹사이트를 출시해 라마3와 직접 대화를 나누는 것도 가능합니다. 현재는 영어로만 서비스되고 있지만 한국어 버전도 조만간 출시될 것으로 보입니다.

메타 AI 챗봇을 체험해보시려면 아래 링크를 참고하세요.

Ollama로 내 PC에서 Llama3 실행하기

Ollama는 오픈소스 언어 모델을 로컬에서 쉽게 실행할 수 있게 해주는 도구입니다. Ollama를 사용하면 라마3를 비롯한 다양한 오픈소스 언어 모델을 내 PC에서 직접 실행해볼 수 있습니다.

Ollama 설치 방법은 다음과 같습니다:

- Ollama 공식 사이트에서 설치 파일 다운로드

- 설치 파일 실행하여 Ollama 설치 (macOS, Linux 지원)

- 터미널에서 다음 명령어로 Llama3 모델 다운로드

ollama run llama3

이제 Ollama를 통해 Llama3 모델을 내 PC에서 실행할 수 있습니다. 모델과 대화를 나누려면 프롬프트를 입력하면 됩니다.

Why is the sky blue?

The short answer: the sky appears blue because of a phenomenon called Rayleigh scattering, named after the British physicist Lord Rayleigh. Here's what happens:

- Sunlight: When sunlight enters Earth's atmosphere, it contains all the colors of the visible spectrum (red, orange, yellow, green, blue, indigo, and violet).

- Molecules: The tiny molecules of gases like nitrogen (N2) and oxygen (O2) in the air scatter (or deflect) the light as it travels.

- Blue light: When the shorter wavelengths of light (like blue and violet) encounter these molecules, they are scattered more than the longer wavelengths (like red and orange). This is because the smaller molecules are better at scattering the shorter wavelengths.

- Our eyes: As we look up at the sky, our eyes perceive the scattered blue light as the dominant color, giving the sky its blue appearance.

The exact shade of blue can vary depending on several factors:

- Time of day: During sunrise and sunset, the sky often takes on more orange or reddish hues due to the scattering of longer wavelengths.

- Atmospheric conditions: Dust, pollution, and water vapor can scatter light in different ways, affecting the apparent color of the sky.

- Altitude and atmospheric pressure: The higher up you go, the bluer the sky appears, as there is less air to scatter the light.

So, to summarize: the sky is blue because of the scattering of sunlight by the tiny molecules in our atmosphere, with shorter wavelengths like blue being scattered more than longer wavelengths.

한글로도 시도를 해보았는데 아직 한글 파인튜닝 모델이 출시되지 않아서 한글로 대화를 나누는 것은 정확도가 떨어지는 것을 볼 수 있었습니다.

한글 파인튜닝 모델이 출시되면 한글로도 대화를 나누는 것이 가능할 것으로 기대됩니다.

지금까지 오픈소스로 공개된 메타의 라마3 언어 모델을 다양한 방식으로 사용는 방법을 알아보았습니다.

허깅페이스를 통해 손쉽게 대화를 하거나, 한글 지원 버전이 출시되면 메타의 AI 서비스를 활용해보는 것도 좋은 방법입니다. 또한 Ollama로 여러분의 PC에서 직접 라마3를 구동해 볼 수도 있습니다. 모델 성능을 최적화하는 과정에서 여러분의 기여가 큰 도움이 될 것입니다.

오픈소스로 공개된 라마3는 향후 다양한 애플리케이션과 서비스에 활용될 것으로 기대됩니다. 기업은 물론 개인 개발자와 연구자분들도 자유롭게 라마3를 활용하여 창의적인 결과물을 만들어낼 수 있을 것입니다.

AI 기술의 대중화와 민주화에 기여할 라마3의 향후 행보가 매우 기대됩니다. 지금 바로 라마3를 사용해 보시고, 여러분만의 아이디어를 실현해보시기 바랍니다.